Die Zeit für die Menschen

Anhand von Wladimir Wernadskijs Konzept der unterschiedlichen Phasenräume (des Unbelebten, des Lebens und der menschlichen Erkenntniskraft) lassen sich die Fehler aufzeigen, die entstehen, wenn man das gesamte Universum aus unbelebten Prozessen aufzubauen versucht und die mögliche Existenz besonderer biologischer oder noetischer Prinzipien ablehnt. In seinem 1930 erschienenen Werk „Die Erforschung des Lebens und die Neue Physik“ spricht Wernadskij direkt den Grundfehler im Newtonschen Kosmos an: Die Begriffe Raum, Zeit, Energie und Materie seien endgültig, sie könnten aus rein unbelebten Experimenten bestimmt werden, und es gebe einen grundlegenden Unterschied zwischen dem untersuchten Universum und dem menschlichen Geist, der es untersucht. Im folgenden werde ich 1. verschiedene Möglichkeiten aufzeigen, warum Raum, Zeit, Energie und Materie im unbelebten, belebten und kognitiven Bereich nicht dasselbe sind und nicht dieselbe Bedeutung haben wie um 1900, 2. erläutern, warum es absurd ist, die Gesetze der Thermodynamik auf lebende und menschliche Systeme oder auf das Universum als Ganzes anzuwenden, und 3. spezifische Anwendungsbereiche von Wernadskijs Sichtweise auf neuartige Zeitbegriffe aufzeigen, insbesondere einzigartiger Aspekte der menschlichen Zeit, die Licht auf die Bedingungen werfen, die erfüllt sein müssen, damit ein Prinzip wirklich „universell“ genannt werden kann.

Einführung

Unter den bekannten physikalischen und lebenden Prozessen ist der Mensch einzigartig: Er hat Eigenschaften, die ihn vollkommen von niedrigeren Lebensbereichen unterscheiden, einschließlich einer absolut einzigartigen Zeitvorstellung. Die besonderen Ausdrucksformen menschlicher Zeit werden klarer, wenn man untersucht, warum andere Zeitformen nicht in der Lage sind, menschliche Aktivitäten zu erfassen. Ein Beispiel dafür ist der in den Gesetzen der Thermodynamik festgelegte Zeitbegriff, dessen falsche Anwendung auf Bereiche außerhalb seines legitimen Geltungsbereichs zu Extrapolationen wie dem „Wärmetod des Universums“ und einer angeblichen Tendenz des gesamten Universums zur „Unordnung“ geführt hat.

Probleme entstehen vor allem dann, wenn ein Begriff oder ein Konzept, das in einem bestimmten Zusammenhang entwickelt wurde, in anderen Zusammenhängen angewendet wird, ohne daß die Eignung des Begriffs oder seine Bedeutung ausreichend überdacht wird. Dies ist besonders häufig der Fall, wenn Begriffe neben der wissenschaftlichen auch eine alltägliche Bedeutung haben (wie z. B. „Funktion“). So werden die Hauptsätze der Thermodynamik, insbesondere der zweite, häufig unangebracht und leichtfertig in Bereichen angewandt, in denen ihre Anwendung zweifelhaft ist, solange sie nicht als erforderliche Grundsätze in diesem Bereich neu entwickelt werden. Ein eklatanter Fehler besteht darin, den Zweiten Hauptsatz der Thermodynamik so zu erklären, daß er eine allgemeine Zunahme der „Unordnung“ beinhaltet, um dann noch den glatten Betrug (oder die extreme Faulheit) zu begehen, dies den Schülern durch die Schilderung chaotischer Schlafsäle und unordentlicher Schreibtische zu veranschaulichen. Der Begriff „Unordnung“ hat selbst bei der Erörterung des physikalischen Konzepts der Entropie im unbelebten Mikrokontext nur eine begrenzte Berechtigung, absolut keine Bedeutung hat er, wenn er auf Objekte im Makrobereich angewendet wird.1

Gute Beispiele für Begriffe, deren Bedeutung sich mit der Entwicklung späterer Erkenntnisse geändert haben, führt der ukrainisch-russische Biogeochemiker Wladimir I. Wernadskij in seinem 1930 erschienenen Werk „Die Erforschung des Lebens und die Neue Physik“2 an, wobei er besonders auf die Fehler der Newtonschen Auffassung des Kosmos – in der der forschende Geist von der erforschten Welt getrennt ist – und auf die sich ändernden Bedeutungen von Raum, Zeit, Energie und Materie hinweist, vier Begriffe, die seiner Auffassung nach für den Wissenschaftler von 1929 eine andere Bedeutung haben als im Jahr 1900.

Die Entwicklung neuer Begriffe, die in der bisherigen Sprache nicht auszudrücken sind, ist der stärkste Ausdruck menschlicher Kreativität: ein Vorgang, der weder durch Logik noch durch irgendeine Form künstlicher Intelligenz erreicht werden kann. Die besondere menschliche Fähigkeit, Metaphern zu erzeugen (Konzepte, die nur durch die spezifische Unfähigkeit vermittelt werden können, sie in der bisherigen Sprache auszudrücken), ist die Grundlage der modernen Wissenschaft und eine immer stärkere und letztlich die stärkste Kraft der Natur.

In diesem Artikel sollen mehrere im ungeeigneten Zusammenhang angewendete Konzepte (die Hauptsätze der Thermodynamik und der Zeitpfeil) behandelt werden, und zwar im Lichte von Wernadskijs Forderung, daß Biologie und menschliche Erkenntniskraft als Grundlage für neue Entwicklungen in der Physik dienen sollten. Dieser Artikel wird

- aufzeigen, daß Raum, Zeit, Energie und Materie im unbelebten, biologischen und kognitiven Bereich nicht dasselbe sind und nicht dieselbe Bedeutung haben wie im Jahr 1900,

- verdeutlichen, daß es absurd ist, die Hauptsätze der Thermodynamik auf lebende und menschliche Systeme oder auf das Universum als Ganzes anzuwenden, und

- spezifische Anwendungen von Wernadskijs Sichtweise auf neuartige Zeitbegriffe aufzeigen, einschließlich einzigartiger Aspekte der menschlichen Zeit, die ein Licht auf die Bedingungen werfen, die ein Prinzip erfüllen müßte, um wirklich als „universell“ zu gelten.

Wernadskijs Denken

In seinem Aufsatz „Die Erforschung des Lebens und die Neue Physik“ von 1930 schrieb Wladimir Wernadskij: „Raum, Zeit, Materie und Energie unterscheiden sich für den Naturforscher des Jahres 1929 deutlich von Raum, Zeit, Materie und Energie des Naturforschers von 1900.“ Die Arbeiten von Max Planck und Albert Einstein über die Quantenwelt und die Relativitätstheorie veränderten die Bedeutung dieser vier Begriffe dramatisch. Auch wenn die Worte gleich blieben, die dahinter stehenden Konzepte waren unvereinbar mit denen von Newton, der schrieb: „Der absolute Raum bleibt vermöge seiner Natur und ohne Beziehung auf einen äußern Gegenstand, stets gleich und unbeweglich“, und: „Die absolute, wahre und mathematische Zeit verfließt an sich und vermöge ihrer Natur gleichförmig, und ohne Beziehung auf irgend einen äußern Gegenstand.“

Nach Einsteins Relativitätstheorie ist der Raum selbst nicht mehr unbeteiligt gegenüber den Objekten im Raum und auch sich selbst gegenüber nicht immer ähnlich: Vielmehr verändert er sich entlang der Bewegungsrichtungen und wird aufgrund der Gravitation gekrümmt. Der Ortsbegriff war zwar nicht verschwunden, aber es änderten sich die Entfernungen zwischen den Orten, und der Raum war nun nicht mehr flach, sondern hatte ein Krümmungmaß.3

Ganz ähnlich steht die Einsteinsche Zeit in erheblichem Widerspruch zur Newtonschen Zeit. Der Zeitfluß variierte nun mit Relativbewegungen und mit Gravitationsfeldern. Bereits der Begriff „Augenblick“ erweist sich für verschiedene Beobachter als unterschiedlich: Für den einen Beobachter können zwei Ereignisse gleichzeitig erscheinen, für einen anderen Beobachter jedoch nicht. Ein bestimmter „Augenblick“ in der Zeit hatte nur noch eine Bedeutung in Bezug auf einen bestimmten Beobachter im Raum (und in der Bewegung). Raum und Zeit waren nicht mehr trennbar oder frei von lokalen Gegebenheiten.

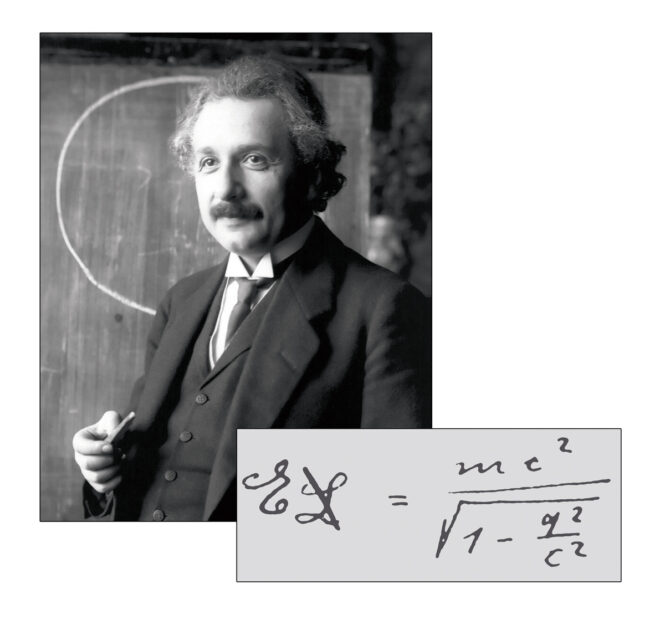

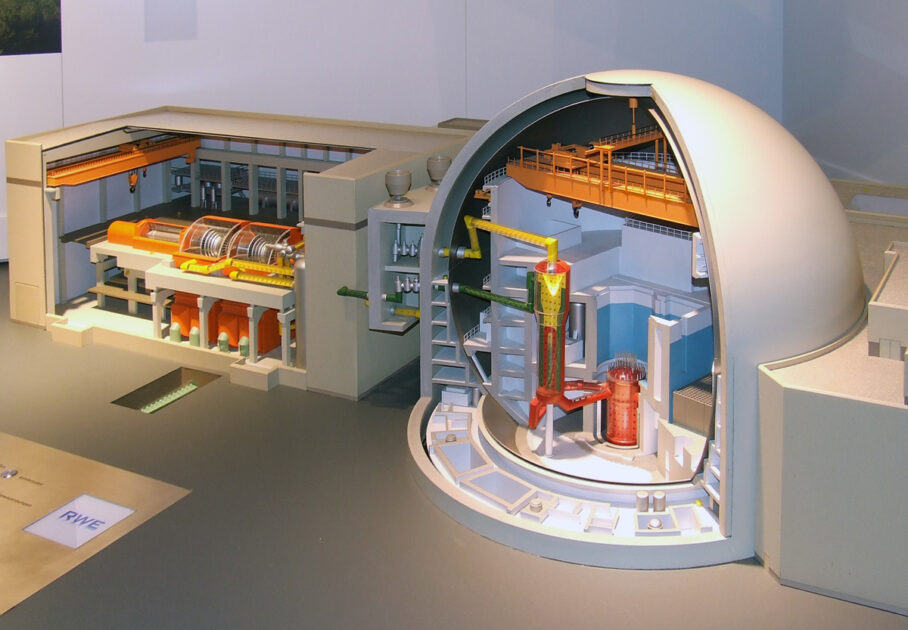

Im Jahr 1900 galten Materie und Energie als etwas Getrenntes; die Erhaltungsgesetze für Materie und Energie besagten, daß alle physikalischen Veränderungen die gleiche Menge an Materie und die gleiche Menge an Energie vor und nach der Veränderung beibehalten. Nach Einstein bezogen sich beide Konzepte jedoch nicht auf völlig getrennte Bereiche, sondern waren durch die Gleichung E = mc2 miteinander verbunden, in der Energie (E) mit Masse (m) mal Lichtgeschwindigkeit (c) im Quadrat in Beziehung gesetzt wird. Dies bedeutet die Möglichkeit, daß Masse verschwindet und zu Energie wird oder daß sich Energie in Materie verwandelt. Arbeiten auf dem Gebiet der Kernphysik bestätigten, daß radioaktive Stoffe erhebliche Energiemengen – in Form von Strahlung und sich schnell bewegenden Teilchen – freisetzen und gleichzeitig ihre Masse geringfügig abnimmt, was mit E = mc2 übereinstimmt.

Ein weiteres Konzept, das in den ersten Jahren des 20. Jahrhunderts eine völlige Veränderung erfuhr, war der Konflikt zwischen Stetigkeit (Kontinuität) und Unstetigkeit (Diskretheit) in der Physik. Eine Größe ist stetig, wenn es zwischen zwei Werten immer noch einen weiteren geben kann; bei einer Unstetigkeit gibt es immer eine kleinstmögliche Änderung. So läßt sich beispielsweise auf einer Geige durch die Bewegung des Fingers entlang des Griffbretts kontinuierlich die Tonhöhe ändern, während die Noten auf einem Klavier diskret sind – es gibt keine Taste zwischen h und c. Auf einer Geige gibt es keine kleinstmögliche Tonänderung, während auf einem Klavier der Halbtonschritt die kleinste Änderung der Tonhöhe ist. (Ein Pianist kann falsche Noten spielen, aber es sind immer noch identifizierbare Noten. Ein Geiger kann Töne erzeugen, die keinen spezifischen Noten der Tonleiter entsprechen.)

Diese Unterscheidung trat in der Physik in zwei Bereichen auf: dem der Materie und dem des Lichts.

Die Vorstellung eines Atoms als kleinstem Bestandteil der Materie, das nicht weiter unterteilt werden kann, ohne seinen Charakter zu verlieren, geht auf Demokrit vor fast 2500 Jahren zurück. Aber solange man einzelne Atome nicht tatsächlich sehen oder messen konnte, ließ sich diese Hypothese auch nicht beweisen. Noch in den letzten Jahrzehnten des 19. Jahrhunderts gab es Physiker, die die Existenz von Atomen leugneten und glaubten, daß Kohlenstoff (zum Beispiel) eine einfache Substanz sei, die sich unbegrenzt in immer kleinere Teile zerlegen ließe. Doch einige Jahrzehnte später zweifelte praktisch niemand mehr an der Existenz von Atomen. Die Möglichkeit, eine bestimmte Anzahl von Atomen zu messen, und das Aufkommen der Nuklearwissenschaft hatten die Kriterien der Debatte um die Frage, ob Atome kontinuierlich oder diskret sind, verändert.

Isaac Newton hatte noch behauptet, Licht bestehe aus Teilchen (und lieferte eine absurde Erklärung für Phänomene wie die Lichtbrechung), doch die Arbeiten von Christiaan Huygens und später von Augustin-Jean Fresnel lieferten überzeugende Argumente für das Verständnis von Licht als Welle, basierend auf ihren Erklärungen für Interferenz, Beugung und Polarisation. Die Korpuskular-(Teilchen-)Theorie des Lichts wurde aufgegeben.4

Im Jahr 1900 entwickelte Max Planck eine neue Hypothese zur Erklärung des von heißen Körpern (z. B. Glühfäden) ausgesendeten Lichtspektrums. Die neue Hypothese – die Planck selbst überraschte – bedingte, daß Licht von Körpern in diskreten Mengen emittiert und absorbiert wird. Licht einer bestimmten Wellenlänge (Farbe) erscheint in kleinsten Einheiten, die nun Photonen genannt werden.5

Damit wurde die Kontinuität für das Licht zu einem Paradox. Seine Wellennatur erklärte Interferenz, Beugung und Polarisation, aber die von Planck untersuchte Schwarzkörperstrahlung und später der von Einstein 1905 untersuchte photoelektrische Effekt erforderten, daß Licht in diskreten Teilchen existiert. Im Jahr 1924 stellte Louis de Broglie die Hypothese auf, daß die Materie selbst Wellencharakter hat, was 1927 experimentell nachgewiesen wurde.6

Im Laufe von nur drei Jahrzehnten hatten sich die vier Grundkonzepte der Physik – Raum, Zeit, Energie und Materie – durch Arbeiten im Bereich des sehr Kleinen (Planck) und des sehr Großen (Einstein) radikal verändert. Wie ließen sich durch Forschungen im Bereich des Lebens diese Grundkonzepte weiter verändern? Wernadskij stellt die Frage:

„Können denn die Lebenswissenschaften nicht die Grundvorstellungen des wissenschaftlichen Universums – die Vorstellungen von Raum, Zeit, Energie, Materie – radikal ändern? Und ist diese Liste der Grundelemente unseres wissenschaftlichen Denkens vollständig?“7

Eine kurze Geschichte der Thermodynamik

Bis zum Ersten Hauptsatz

Vor der Entwicklung der Thermodynamik um 1800 betrachtete man Wärme, Materie und mechanische Energie ganz unterschiedlich. Im späten 17. und 18. Jahrhundert wurde Wärme mit einer hypothetischen Substanz namens Phlogiston in Verbindung gebracht, die in brennbaren Körpern existiert und bei der Verbrennung als Hitze freigesetzt wird. Dies diente als Erklärung dafür, warum Asche weniger wog als die verbrannten Stoffe: Sie hatten ihr Phlogiston verloren. Der große Chemiker Antoine Lavoisier (1743–1794) wies jedoch durch sorgfältige Messungen nach, daß die Masse von Metallen bei ihrer Verbrennung (oder auch beim Verrosten) zunimmt, wodurch die bisherige Theorie widerlegt war. Lavoisier führte als neues Konzept die Kalorik ein, welche flüssigkeitsartige Eigenschaften hätte und bei Erwärmung in die Gegenstände fließe.8 Nach dieser Theorie war die Kalorik eine Substanz, deren Gesamtmenge erhalten blieb, wenn sie von einem heißen Körper zu einem kalten floß oder von ihm chemisch freigesetzt wurde. Als Anfang des 19. Jahrhunderts das wirtschaftliche Potential von Wärmekraftmaschinen deutlich wurde, versuchte Sadi Carnot, die potentielle Abgabeleistung solcher Maschinen zu verstehen. Er untersuchte ihre Funktionsweise und entwickelte spezifische mathematische Beziehungen zwischen dem Wärmestrom (als Kalorik) und der potentiellen geleisteten physikalischen Arbeit. Außerdem berechnete er den maximalen theoretischen Wirkungsgrad einer Wärmekraftmaschine.

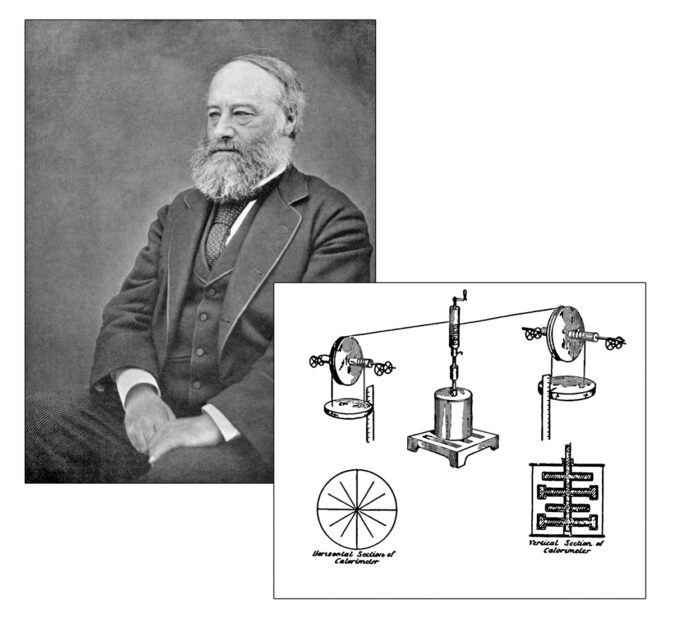

Wärme und mechanische Arbeit wurden in der Folge unter dem gemeinsamen Begriff Thermodynamik zusammengefaßt. In den 1840er Jahren führte James Prescott Joule Experimente durch, bei denen ein fallendes Gewicht eine Paddelanordnung in einer Flüssigkeit in Gang setzte und diese erwärmte: mechanische Arbeit wurde in Wärme umgewandelt, was bedeutete, daß Kalorik (sofern es sich um eine reale Substanz handelte) erzeugt wurde und mechanische Energie verschwand. Joule vereinheitlichte Wärme und mechanische Energie, indem er ein mechanisches Wärmeäquivalent festlegte und die Kalorie (ein Maß für Wärme) mit der mechanischen Energie (heute in Joule gemessen) in Beziehung setzte.9 Der Grundsatz der Energieerhaltung konnte nun streng vom Bereich der mechanischen Dynamik auf den Bereich der Thermodynamik ausgedehnt werden. Bei Prozessen konnte es sich um eine Umwandlung zwischen (mechanischer) Energie und Wärmefluß, aber niemals um die Erzeugung oder Zerstörung der thermodynamischen Gesamtenergie handeln, ein Konzept, das beide Bereiche umfaßt.

Weitere Untersuchungen über die Beziehungen zwischen Wärme und mechanischer Arbeit ergaben, daß Wärme nicht als Substanz vorliegt. Man kann zwar sagen, daß ein Gas unter bestimmten Bedingungen und bei einer bestimmten Temperatur eine bestimmte Menge an Energie enthält, man kann aber nicht sagen, daß es eine bestimmte Menge an Wärme, an Kalorik, enthält. Dies ergab sich aus verschiedenen Experimenten, bei denen ein Gassystem von einem Zustand in einen anderen überführt wurde, was zu unterschiedlichen Mengen an Arbeit oder Wärmefluß führte, je nachdem, welche Mittel eingesetzt werden, um von einem Zustand zu dem anderen zu gelangen. Man kann also nicht sagen, daß ein Zustand eines Gases einen spezifischen Wärmeüberschuß im Vergleich zu einem anderen Zustand enthält. Die kalorische Wärmetheorie verblaßte, und Wärme wurde nicht als eine Substanz betrachtet, die zwischen Körpern fließt, sondern nur als ein Maß für den Fluß selbst. Das heißt, der Wärme-Fluß konnte gemessen werden, aber der Wärme-Inhalt existierte nicht mehr als wissenschaftliches Konzept.

Die Ergebnisse dieser Forschung fanden ihren Ausdruck in den sogenannten Hauptsätzen der Thermodynamik, die sowohl die Wärme als auch die Mechanik umfassen (daher der Name).

Der Erste Hauptsatz der Thermodynamik besagt, daß die gesamte Energiemenge in einem geschlossenen System erhalten bleibt. Die Energie kann in verschiedenen Formen vorliegen und umgewandelt werden, z. B. als verrichtete mechanische Arbeit, als mechanisches und Gravitationspotential, als chemisches Potential (die Fähigkeit eines Brennstoffs, bei der Verbrennung Wärme abzugeben), als Wärmefluß und als Zustandsenergie eines Gases unter verschiedenen Volumen-, Druck- und Temperaturbedingungen. Zwischen all diesen Energien können Übergänge stattfinden, aber kein Prozeß führt dazu, daß Energie entsteht oder verloren geht.10 Der Motor eines Lastwagens beispielsweise wandelt die chemische Energie des Kraftstoffs in Wärme und mechanische Bewegungsenergie um, die dann auf die Räder übertragen wird. Bremsen wandeln Bewegung in Wärme (und mechanische Abnutzung) um. Auch der Luftwiderstand wandelt einen Teil der Lkw-Bewegung in Wärme und Turbulenzen um, aber in keinem dieser Fälle wird die Gesamtenergiemenge verändert.

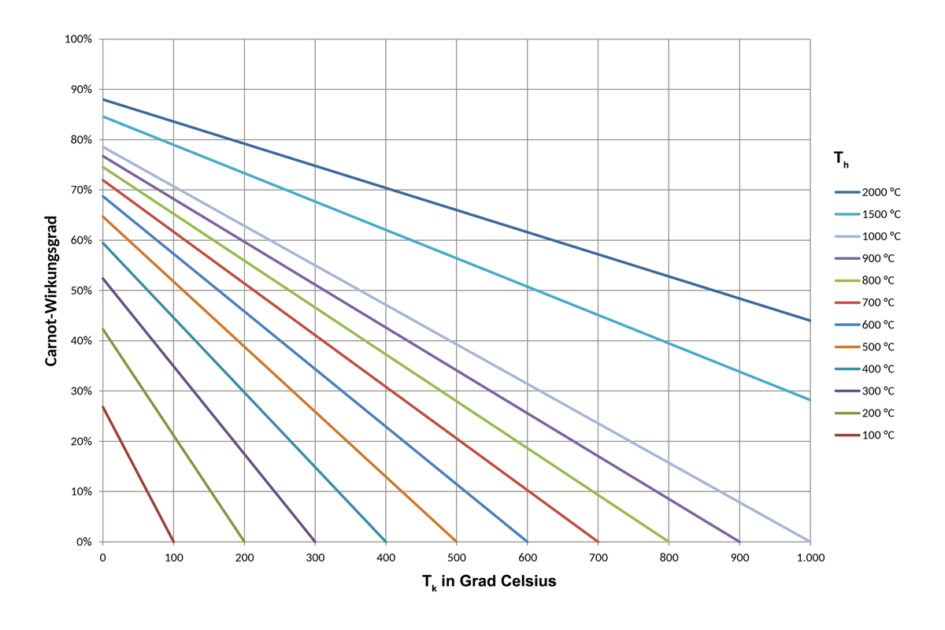

In Anlehnung an Carnots Arbeit wurde ein spezifischer möglicher Wirkungsgrad für die Umwandlung von Wärmefluß in mechanische Arbeit entwickelt. Bei zwei Wärmespeichern unterschiedlicher Temperatur, einem heißem (Th) und einem kalten (Tk), ist der maximale Anteil der Wärme aus dem warmem Speicher, der in Arbeit umgewandelt wird und nicht durch die bloße Erwärmung des kälteren Speichers verloren geht, (Th – Tk)/Th, heute bekannt als Carnot-Wirkungsgrad.11 In umgekehrter Richtung betrachtet, ergibt sich aus dieser Beziehung auch der maximal mögliche Wirkungsgrad eines Kühlkreislaufs, d. h. die Menge an Arbeit, die erforderlich ist, um einen Wärmefluß von einem kälteren zu einem wärmeren Speicher zu bewirken: Die mechanische Arbeit des Motors treibt einen Kompressor an, so daß ein Wärmefluß vom (kühlen) Inneren eines Kühlschranks zur (wärmeren) Luft in der Küche entsteht. Dieser maximale Wirkungsgrad ergibt sich aus allgemeinen Überlegungen zu Gassystemen und der Energieerhaltung.12

Kombiniert man die Prinzipien der mechanischen Physik mit diesem Hauptsatz der Thermodynamik, läßt sich beschreiben, wie sich ein wärmemechanisches System verändert. In jedem Moment kann man, wenn man den Zustand des Systems und seine aktuelle Veränderung kennt, den Zustand und die Art der Veränderung bestimmen, die es im nächsten Moment einnehmen wird, ebenso wie den Zustand und die Art der Veränderung, die es im vorangegangenen Moment gehabt haben muß.13 Für diese Prinzipien sind Vergangenheit und Zukunft gleichwertig, sie unterscheiden sich nur dadurch, daß sie zeitlich in entgegengesetzte Richtungen verlaufen, haben aber ansonsten keinen grundlegenden Unterschied.14 Die Zukunft kann genauso exakt bestimmt werden wie die Vergangenheit. Auf diese Weise sind Vergangenheit und Zukunft, vorwärts und rückwärts in der Zeit, analog zu links und rechts: Sie können als Gegensätze beschrieben werden, aber es gibt keinen grundlegenden Unterschied zwischen den beiden Richtungen selbst.15 Diese physikalischen Prinzipien lassen sich somit als zeit-symmetrisch oder reversibel bezeichnen. Nichts in den Phänomenen, die durch die physikalische Dynamik oder den Ersten Hauptsatz der Thermodynamik beschrieben werden, dient als Grundlage für die Unterscheidung zwischen Vergangenheit und Zukunft oder zwischen vorher und nachher – es gibt nichts, was eine bestimmte Zeitrichtung definiert, abgesehen davon, daß sie einfach Gegensätze sind.16

Der Zweite Hauptsatz entsteht

Ausgehend von den allgemeinen Beobachtungen, daß Wärme nie von selbst von einem kalten zu einem wärmeren Objekt fließt, daß Gase eher diffundieren als sich konzentrieren und daß die bei fast jedem Prozeß auftretende Reibung eine bestimmte Zeitrichtung erzeugt, indem sie Bewegung in Wärme umwandelt, wurde ein neues Konzept erdacht. Das, was heute als Zweiter Hauptsatz der Thermodynamik bekannt ist, wurde Mitte bis Ende des 18. Jahrhunderts u. a. von Rudolf Clausius, Ludwig Boltzmann, Josiah Willard Gibbs und Max Planck entwickelt.

Um diese neue Hypothese ausdrücken zu können, war ein neuer Begriff erforderlich: „Entropie“ – ein Begriff, der grob als Maß für die Menge an Energie in einem System verstanden werden kann, die nicht zur Verrichtung von Arbeit zur Verfügung steht. Clausius verstand die Entropie als Funktionszustand eines Gases – als neue Funktion seiner Masse, seines Volumens, seiner Temperatur und seines Drucks – und stellte fest, daß diese Größe in einem geschlossenen System (ohne äußere Arbeit oder Wärmefluß) niemals abnimmt.17 Von der Gesamtenergie in einem System nimmt der Anteil, der „frei“ ist, um Arbeit zu verrichten, mit der Zeit ab, und die Entropie nimmt zu. Die Entropie ermöglichte es, die Richtung der Zeit zu definieren: Die Entropie eines geschlossenen Systems kann „danach“ nie niedriger sein als „davor“. Anstatt daß vorher und nachher einfach Gegensätze waren, definierte ein spezifisches Konzept, die Entropie, nun einen Zeitpfeil. Nachher ist die Entropie höher als vorher.18

Nach dem Zweiten Hauptsatz wird zwischen reversiblen und irreversiblen Prozessen unterschieden. Bei reversiblen Prozessen findet keine Veränderung der Entropie statt. Beispiele hierfür sind das Schwingen eines Pendels im Vakuum (ohne Reibung), die Bewegung eines Planeten um einen Stern oder die ideale Kompression und Expansion eines Gasdruckstoßdämpfers.19 Reversible Prozesse haben keine Eigenzeit oder einen Endzustand, auf den sie zulaufen. Ein solches theoretisches Pendel würde ewig auf die gleiche Weise hin und her schwingen. Wenn man sich ein kurzes Video des Pendels anschaut, kann man nicht sagen, ob das Video von heute, von vor einer Woche oder von tausend Jahren in der Zukunft stammt. Das Pendel würde nie aufhören zu schwingen, und seine Vergangenheit wäre genauso wie seine Zukunft.

Bei irreversiblen Prozessen kommt es jedoch zu einer Veränderung der Entropie, die sich mit fortschreitender Zeit immer weiter erhöht. Beispiele für irreversible Prozesse sind die Erzeugung von Wärme durch Reibung, die Ausdehnung eines Gases, ohne daß dabei Arbeit verrichtet wird, oder der Wärmefluß von einem heißeren zu einem kälteren Körper.20 Wenn man beispielsweise einen Eiswürfel in eine Tasse Tee gibt, ist es klar, daß die kühlere Tasse Tee ohne den Eiswürfel der heißen Tasse Tee mit dem Eiswürfel nachfolgt. Da irreversible Aspekte in fast jedem Prozeß vorhanden sind, hat das Konzept eines wirklich reversiblen Prozesses nur noch eine eher theoretische Bedeutung.

Die Atomtheorie der Materie hat das Verständnis der Entropie verkompliziert, was durch statistische Anwendungen gelöst werden konnte. Man ging davon aus, daß sich die einzelnen Atome und Moleküle, aus denen sich die Gase zusammensetzen, auf der Mikroebene nach dynamischen (reversiblen) physikalischen Gesetzen verhalten, und so ergab sich die Schwierigkeit, eine Zunahme der Entropie (Irreversibilität) auf der Makroebene mit der reversiblen Natur der Komponenten, aus denen diese Makrozustände bestehen, in Einklang zu bringen. Wie könnte es eine Eigenrichtung der Zeit geben, wenn das Verhalten aller Teilchen, aus denen sich irreversible Prozesse zusammensetzen, einzeln zeitlich umkehrbar wäre?21 Bei einem Gas beispielsweise, dem man erlaubt, sich auszudehnen (z. B. durch Öffnen des Ventils an einem Drucklufttank), wäre dies der Fall. Doch obwohl die Bewegungen der einzelnen Teilchen umgekehrt werden könnten, ohne die physikalischen Gesetze zu verletzen, erleben wir nicht, daß sich das Gas spontan zusammenzieht und in einen Behälter strömt. Warum?

Boltzmann entwickelte eine statistische Mechanik, um die Entropie aus einem anderen Blickwinkel zu erklären. Anstatt eine Funktion der Bedingungen eines Gases als Ganzes zu sein, kann das Gas als Funktion der Anzahl möglicher Konfigurationen verstanden werden, die die Teilchen eines Gases einnehmen können, welche einem bestimmten Makrozustand entsprechen.22 Beispielsweise ist die Anzahl der Möglichkeiten, daß Gaspartikel in gleicher Anzahl in zwei miteinander verbundenen Gasbehältern vorkommen, immens größer als die Anzahl der Konfigurationen, in denen sie alle in nur einem der Behälter zu finden sind. Daher hat die gleichmäßige Verteilung des Gases mit mehr möglichen Konfigurationen eine höhere Entropie. Boltzmann meint, daß die Tatsache, daß es so viele Möglichkeiten gibt, das Gas gleichmäßig auf die beiden Tanks aufzuteilen, die Ursache dafür ist, daß sich das Gas mit der Zeit ausdehnt und beide Tanks füllt. Mit diesen Verfeinerungen wurde das Mißverhältnis zwischen reversiblen Mikrophänomenen und irreversiblen Makrophänomenen überbrückt.23

Die Gesetze der Thermodynamik, kombiniert mit allen anderen Gesetzen der mechanischen Physik, vereinen Wärme und Mechanik und liefern einen Zeitpfeil. Während es in der Physik der reversiblen Prozesse nur ein Vorher und ein Nachher als Gegensätzlichkeit gibt, verleihen die Gesetze der irreversiblen Prozesse der Entwicklung der für sie geltenden Systeme eine eindeutige zeitliche Richtung. Der Zweite Hauptsatz gibt zur Unterscheidung von vorher und nachher eine Eigenmetrik vor: die Entropie nimmt mit der Zeit zu.

Der Erste Hauptsatz der Thermodynamik ist nicht universell

Der Erste Hauptsatz der Thermodynamik besagt, daß bei allen physikalischen Prozessen Energie weder erzeugt noch zerstört wird. Einsteins Nachweis der Wechselbeziehung zwischen Materie und Energie zeigt zwar, daß dieser Grundsatz nicht stimmt, da Energie und Masse ineinander umgewandelt werden können (wie bei nuklearen Prozessen), doch wir wollen uns hier vor allem mit der sich verändernden Natur von „Energie“ beschäftigen, und zwar in zweierlei Hinsicht: 1. Energie wird tatsächlich von Menschen geschaffen, und 2. im Rahmen einer neugefaßten Bedeutung unterscheidet sich wirtschaftliche „Energie“ von der Energie der Physik, wie wir bei der Betrachtung der Energieflußdichte sehen werden.

In den 1800er Jahren, als die Gesetze der Thermodynamik entwickelt wurden, hätte jeder Versuch, die Gesamtenergie unseres Planeten zu messen, zu einem dramatischen Fehler geführt. Bei einer solchen Schätzung wären Faktoren wie Sonnenlicht, chemische Verbindungen (z. B. in der lebenden Materie und in den Kohlenwasserstoffen der Erdkruste), Erhebungen physischer Strukturen (Schwerkraftpotential), die Strömung von Wind und Wasser und die hohe Temperatur des Erdkerns berücksichtigt worden. Selbst wenn eine solche Schätzung der auf dem Planeten insgesamt verfügbaren Energie recht schwierig wäre, ist dies nicht das größte Problem bei einem solchen Unterfangen. Man sollte vielmehr bedenken, was überhaupt nicht erfaßt worden wäre. Eine solche Erhebung um 1800 hätte weder das Potential der Kernspaltung von Uran und Thorium noch das Potential der Kernfusion von Deuterium berücksichtigt. Die Schätzung der Weltenergie wäre nicht nur wegen der unzureichenden Kenntnisse über die Zusammensetzung des Erdkörpers, sondern auch wegen der Unvollständigkeit des Bereichs möglicher Energiequellen – die Kernprozesse waren unbekannt – völlig falsch gewesen.

Die entscheidende Frage ist: Hat die Menschheit durch die Entwicklung der Atomwissenschaft die Energiemenge auf der Erde erhöht oder nur bereits vorhandene Energie entdeckt?

Widersteht man der Versuchung, die Frage physikalisch zu beantworten, die eine spezifisch menschliche Antwort ausschlösse, kann man eine ehrliche Antwort geben: Wir haben die der menschlichen Gattung zur Verfügung stehende Energie erhöht und unsere wirtschaftlichen Möglichkeiten erweitert. Wir haben etwas geschaffen, das man als wirtschaftliche Energie bezeichnen könnte. Zwischen beiden Arten von „Energie“ läßt sich eine nützliche Unterscheidung treffen: Beide beziehen sich auf etwas, das wir in der äußeren physischen Welt entdeckt haben, und gleichzeitig auf ein geistiges Werkzeug, das wir einsetzen, um unser Denken und unsere Macht zu erweitern. Der Mensch erzeugt Ressourcen, einschließlich Energie.24

Ein weiteres Beispiel verdeutlicht, wie wichtig es ist, die Qualität der Energie zu berücksichtigen. Dabei müssen wir nicht nur die Energiemenge, sondern die Energieflußdichte betrachten, also die Konzentration der auf einen Prozeß angewandten Energie. Nehmen wir als Beispiel die Beheizung eines Hauses. Wir betrachten zwei Möglichkeiten der Wärmeversorgung. Die erste ist die Verwendung von Brennstoff zur direkten Erzeugung von Wärme in der Wohnung durch Verbrennung (z. B. von Erdgas), die zweite die Verwendung von Brennstoff zur Erzeugung von Strom in einem Kraftwerk und die anschließende Verwendung dieses Stroms zum Betrieb einer Wärmepumpe. Im ersten Fall wird die Effizienz des Brenners oder Kessels anhand des jährlichen Brennstoffnutzungsgrads gemessen, der bei einem typischen modernen Gerät etwa 85 % beträgt. Das bedeutet, daß 85 % der im Brennstoff enthaltenen Wärme an die Luft im Haus abgegeben wird.

Betrachten wir nun den Fall, daß das Erdgas zur Stromerzeugung verwendet wird, um dann eine Wärmepumpe zu betreiben. Ein typisches Erdgaskraftwerk wandelt nur etwa 42 % der Wärme des Erdgases in Elektrizität um. Da Elektrizität jedoch eine hochwertigere und dichtere Form von Energie ist als bloße Wärme, kann sie viel mehr leisten als Wärme: Elektrizität kann Motoren antreiben, Elektronik betreiben, Metalle erzeugen usw. Und selbst beim Heizen eines Hauses ist Strom effizienter als Wärme selbst.25

Beim Einsatz einer Wärmepumpe, die Wärme aus der Außenluft in das Haus befördert („pumpt“), wird der Strom aus dem Kraftwerk mit einer Leistungszahl (COP) für die Wärmepumpe multipliziert, einem Maß für die dem Haus zugeführten Wärme im Verhältnis zu der von der Pumpe zugeführten Energie. Bei herkömmlichen Wärmepumpen liegt die Leistungszahl im Bereich von 2 bis 4, was bedeutet, daß ein Vielfaches der Energie, die für den Betrieb der Wärmepumpe aufgewendet wird, an Wärme ins Haus geliefert wird. Multipliziert man die Stromumwandlungsrate (42 %) mit der COP, erhält man einen Wert von 84–168 %. Das bedeutet, daß das Haus eine Wärme erhalten hat, die 84–168 % der Wärmeenergie des Erdgasbrennstoffs entspricht. Bei einer direkten Verbrennung von Erdgas in einem Ofen würden 85 % der Wärme des Erdgases an die Wohnung abgegeben.

Die Umwandlung von Erdgas in Elektrizität und der Einsatz einer mit dieser Elektrizität betriebenen Wärmepumpe kann daher etwa doppelt so viel Heizenergie liefern (168 % im Vergleich zu 85 %) wie die direkte Verwendung von Erdgas als Wärmequelle. Und dies ist nur ein Fall, in dem die Auswirkungen vergleichbar sind: die Bereitstellung von Wärme. Ohne Umwandlung in Elektrizität kann Erdgas nicht zum Betrieb eines Telefons, eines Roboters in einer Fabrik oder einer Ampelanlage verwendet werden. Keine Menge Erdgas als Chemikalie kann ein Röntgenbild eines gebrochenen Knochens erzeugen.

Dies ist ein einfaches Beispiel dafür, was Lyndon LaRouche in seinem Wirtschaftslehrbuch „Was Sie schon immer über Wirtschaft wissen wollten“ als „merkwürdiges Charakteristikum“ der technologischen Entwicklung bezeichnet, wonach

„wir viel mehr Arbeit mit einem Bruchteil der insgesamt zugeführten Kraft leisten können, wenn diese eine hohe Energieflußdichte hat, als mit der gesamten Kraft, wenn diese eine relativ niedrigere Energieflußdichte hat. Es scheint dadurch so, als ob ein kleineres Quantum Kraft mehr Arbeit verrichte als ein größeres Quantum.“26

Die „Energie“ der Elektrizität kann in denselben physikalischen Einheiten gemessen werden wie die „Energie“ der Wärme oder die chemische „Energie“ der Molekularstruktur, aber diese Einheiten drücken den wirtschaftlichen Nutzen (Leistung) dieser Energie nicht vollständig aus. Durch die Betrachtung der Energieintensität können wir zwischen verschiedenen Ebenen des Energiepotentials unterscheiden, wie z. B. den Möglichkeiten

- einer holzbetriebenen Wirtschaft, in der Energie zum Heizen, Kochen, für einige Materialbehandlungen und für die Metallurgie genutzt werden kann,

- einer kohlebetriebenen Wirtschaft, in der Dampfmaschinen wirtschaftlich genutzt werden können, um Wärme in Bewegung umzuwandeln, was drastische Veränderungen in der Produktion und im Transportwesen ermöglicht,

- einer strombetriebenen Wirtschaft, in der Energie entlang eines Drahtes bewegt werden kann, anstatt den Brennstoff zu transportieren, wobei die Produktionsmöglichkeiten durch Motoren gesteigert werden, die Metallurgie durch Elektrolyse betrieben wird, die Kommunikation sich grundlegend ändert und die Computerautomatisierung die produktive Arbeit erweitert, bis hin zu

- einer quantenphysikalischen und nuklearen Wirtschaft mit dramatisch höheren Energiekapazitäten,27 Laser- und Elektronenstrahltechnologien und, mit der Kernfusion, dem Potential, die Kontrolle über das innere Sonnensystem zu erlangen.28

Während der Erste Hauptsatz der Thermodynamik auf physikalischer Ebene gilt, wo Energie weder erzeugt noch vernichtet wird (mit Ausnahme subatomarer Prozesse, bei denen Energie und Materie durch E = mc2 miteinander verbunden sind), nimmt die der menschlichen Wirtschaft zur Verfügung stehende „wirtschaftliche Energie“ durch den kreativen Entdeckungsprozeß des Menschen eindeutig zu. Dieser Anstieg ist sowohl in absoluten Zahlen als auch dann zu beobachten, wenn weniger Gesamtenergie aus den Brennstoffquellen gewonnen wird, indem diese konzentriertere Energie effektiver genutzt wird.

Betrachtet man das Universum als Ganzes (einschließlich der Biosphäre des Lebens und der Noosphäre der menschlichen Erkenntnis), so ist der Erste Hauptsatz der Thermodynamik kein universelles Prinzip.

Wüste Fehlanwendungen des Zweiten Hauptsatzes

Die Bedeutung des Zweiten Hauptsatzes der Thermodynamik wurde in der Folge stark vereinfacht und sein Anwendungsbereich erheblich erweitert, was ihm eine völlig fremde populärwissenschaftliche Bedeutung verleiht. Die zwei wichtigsten Fehlanwendungen sind die Vorstellung vom „Wärmetod des Universums“ und die Ansicht, der Zweite Hauptsatz lasse auf eine universelle Zunahme der „Unordnung“ schließen.

William Thompson (später Lord Kelvin) hat als erster die Theorie entwickelt, daß sich alle Formen potentieller Energie zwangsläufig in mechanische Bewegung und Wärme auflösen: „Das Ergebnis wäre unweigerlich ein Zustand der Ruhe und des universellen Todes, wenn das Universum endlich ist und gezwungen ist, bestehende Gesetze zu befolgen“. Sein Kollege Hermann von Helmholtz nannte den „Wärmetod“ des Universums den Endzustand, der erreicht würde, wenn keine Energie mehr für irgendwelche Prozesse zur Verfügung stünden. Dies ist die ultimative Extrapolation: die Anwendung des aktuellen Wissens (damals waren die nuklearen Prozesse noch unbekannt29) auf das gesamte Universum, über das es immer anmaßend sein wird, auch nur annähernd ein vollständiges Verständnis zu erlangen. Da die Entdeckungen des Menschen unsere Beziehung zum Rest des Universums verändern und die Zahl der noch zu machenden Entdeckungen immer unendlich ist, sind die „Naturgesetze“ niemals fix.

Das andere Problem, das den Zweiten Hauptsatz plagt und ihn als legitimes und nützliches physikalisches Prinzip (in seinem Zuständigkeitsbereich) fragwürdig macht, ist die Vorstellung, daß das Universum angeblich mit der Zeit „unordentlicher“ wird. Boltzmann verwendete in seiner Diskussion über die Entropie tatsächlich das Wort „Unordnung“, allerdings in einem Kontext, in dem er die Eigenschaft von Gasmolekülaggregaten behandelte, d. h. der Anzahl von Zuständen, in denen sich die Gasteilchen innerhalb einer bestimmten Makroebene von Temperatur, Druck und Volumen befinden könnten. Beispielsweise wäre ein höherer Temperaturzustand, der eine größere Teilchenbewegung zuließe, ein Zustand mit höherer Entropie. Die Verwendung des Wortes „Unordnung“ bezieht sich auf Aggregate mikroskopischer Teilchen, die sich selbstständig bewegen und interagieren. Das gilt natürlich nicht für Gegenstände auf einem Schreibtisch, schmutzige Wäsche, die auf dem Boden verteilt ist, usw. Die Wäschestücke bewegen sich nicht in großen Haufen, die miteinander kollidieren und nach statistischen Regeln kinetische Energie abgeben. Bücher in einer Bibliothek fallen nicht von selbst aus dem Regal und geraten nachts in Unordnung, wenn das Bibliothekspersonal sie nicht beaufsichtigt. Gegenstände dieser Art bewegen sich aufgrund äußerer Ursachen: Menschen. Sie bewegen sich nicht spontan und eigenständig in Zustände, in denen eine größere Vielfalt möglicher Verteilungen herrschen.

Es gibt kein allgemeingültiges Gebot, daß die „Unordnung“ zunimmt, in welchem Zusammenhang auch immer man das Wort anwenden möchte. Der Zweite Hauptsatz der Thermodynamik ist, wie sein Name schon sagt, ein Gesetz der Thermodynamik, nicht der Biologie oder der menschlichen Gesellschaft. Die einzige legitime Anwendung des Zweiten Hauptsatzes auf umfangreichere Prozesse besteht darin, ihre thermodynamischen Veränderungen auf der Grundlage ihrer Bestandteile zu untersuchen.

Der Zweite Hauptsatz der Thermodynamik ist nicht universell

Abgesehen von diesen wüsten, unverantwortlichen Extrapolationen von Logik und Linguistik liefern die Prozesse des Lebens und der menschlichen Erkenntnis weitere Beispiele dafür, daß der Zweite Hauptsatz nicht universell ist. Obwohl der Zweite Hauptsatz eigentlich nicht auf Prozesse im Makromaßstab angewandt werden kann, für die er keine Relevanz hat, lohnt es sich angesichts der weit verbreiteten Konzepte über universelle „Entropie“, sich mit Ordnung und Komplexität in größeren Maßstäben zu befassen, mit dem Vorbehalt, daß sich diese Diskussion auf die allgemein verwendeten Begriffe Entropie und Unordnung und nicht auf das eigentliche physikalische Konzept bezieht.

Ein nützliches wirtschaftliches Konzept hilft, dies zu verdeutlichen – das Konzept der Notwendigkeit des Fortschritts. In seinem Wirtschaftslehrbuch30 entwickelt Lyndon LaRouche ein globales Maß für wirtschaftlichen Fortschritt: die potentielle relative Bevölkerungsdichte einer Gesellschaft als Funktion ihrer wissenschaftlichen und kulturellen Praxis. Wie viele Menschen können relativ zum Umfang der menschlichen Landverbesserung auf einer gegebenen Fläche leben? Dies ist, grob gesagt, die potentielle relative Bevölkerungsdichte (PRBD). Wirtschaftlicher Wert liegt in der Erhöhung des Zuwachses der PRBD. LaRouche schreibt, es sei zwar offensichtlich, daß technologischer Rückschritt zwangsläufig zu einer Abnahme der PRBD führe, aber die Folgen einer bloßen Fortschrittsunterbrechung seien weniger klar. LaRouche argumentiert, daß die physischen Kosten für die Bereitstellung der grundlegender Ressourcen in einer technologisch statischen Gesellschaft mit der Zeit zwangsläufig ansteigen (durch einen zunehmend schwierigen Abbau usw.), und diese steigenden Kosten führen zu einer Verringerung der wirtschaftlichen Fähigkeiten insgesamt. Ohne ständige technologische Verbesserungen wird sich die Gesellschaft zurückentwickeln; ein Stillstand ist unmöglich.

In diesem Zusammenhang können die zunehmende Entropie und die abnehmende freie thermodynamische Energie physikalischer Systeme als Analogie zur relativen, lokalen Rückentwicklung eines Systems betrachtet werden, das ganz allgemein durch seinen unsteten Fortschritt gekennzeichnet ist. Deutliche Beispiele hierfür finden sich in den sehr ähnlichen Bereichen des Lebens auf evolutionären Zeitmaßstäben und in der menschlichen Wirtschaft.

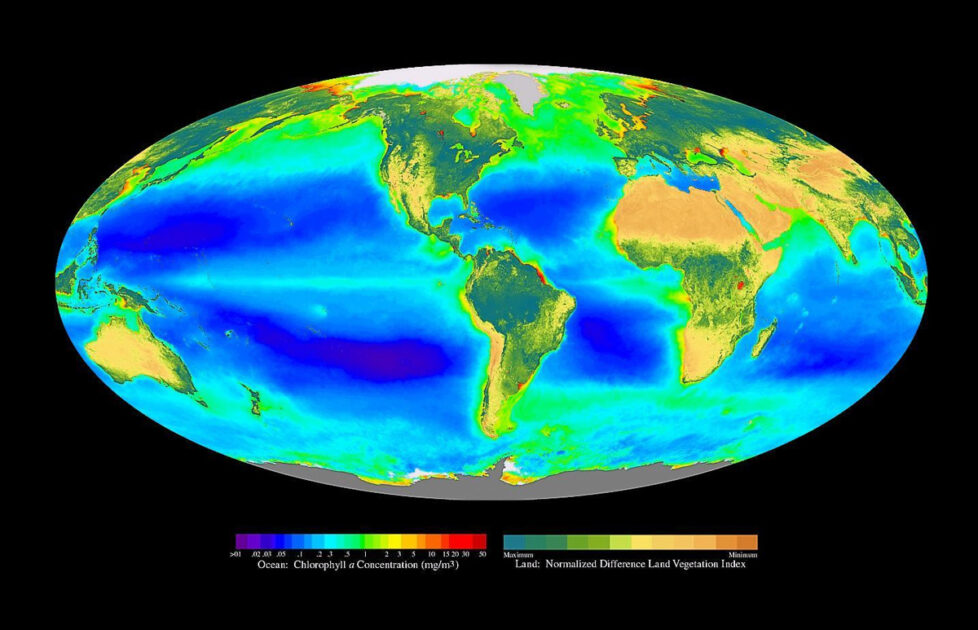

Betrachten wir die Entwicklung der Photosynthese. Vor der Entwicklung von Lebensformen, die die Energie des Sonnenlichts nutzen konnte, basierte das Leben auf der Erde auf chemischer Energie, wie sie beispielsweise von Organismen genutzt wurde, die in der Nähe von Tiefseeschloten (Schwarzen Rauchern) lebten, von denen energiereiche Moleküle wie Schwefelwasserstoff ausgestoßen wurden. Die dem Leben insgesamt zur Verfügung stehende Energie war gering und wurde durch Prozesse in der Tiefe der Erde erzeugt. Aus thermodynamischer Sicht wäre das Energiepotential dieser Moleküle (und der Prozesse, die sie erzeugen) irgendwann erschöpft, wenn die Gase aus der Erdkruste entweichen und durch die Abkühlung der Erde weniger von ihnen produziert werden. Ein heutiger Umweltschützer hätte vielleicht einen sparsamen Umgang mit dem knappen Schwefelwasserstoff und Maßnahmen zu seiner effizienteren Nutzung gefordert, doch das Leben hat einen anderen Weg eingeschlagen. Die Entwicklung der Photosynthese bedeutete, daß dem Leben nun eine völlig neue und unermeßlich große Energiequelle – die Sonne – zur Verfügung stand, mit der erheblich mehr biologisches Material erhalten und ein viel höherer Energiefluß ermöglicht werden konnte. Die biogeochemische Energie lebender Materie würde sich erhöhen. Später wurden durch die Verlagerung des Lebens an Land und die dafür erforderlichen neuen Strukturen und Prozesse zusätzliche photosynthetische Fähigkeiten freigesetzt.

Bei der Untersuchung kleiner physikalischer Systeme scheint zwar die lokale Tendenz in Richtung abnehmender freier Energie zu gehen, doch die Charakteristik des Lebens als Ganzes und der sich entwickelnden menschlichen Gesellschaft ist dem genau entgegengesetzt. Oder besser gesagt, nicht genau entgegengesetzt, denn der Aufwärtstrend erfolgt in Sprüngen und nicht in Form einer kontinuierlichen Abnahme der freien Energie, wie es der Zweite Hauptsatz der Thermodynamik ausdrückt. Ein „vermenschlichtes“ System aus heißem Gas mag mit Bestürzung und Schrecken auf die lokal abnehmende freie Energie blicken, aber Leben und menschliche Erkenntnis lassen sich nicht durch das unbelebte Konzept freier Energie einschränken.

Wernadskij zeigt, daß die biogeochemische Energie des Lebens im Laufe der Zeit zugenommen hat. In einer Rede im Jahr 192831 über die Evolution der Arten stellt Wernadskij sein sogenanntes „zweites biogeochemisches Prinzip“ vor, das besagt, daß die Evolution der Arten eine bestimmte Richtung hat, nämlich hin zu den Arten, die ihre chemische und energetische Wirkung auf die Umgebung erhöhen (in Wernadskijs Worten: die biogene Wanderung der Atome erhöhen):

„Die Evolution lebender Formen im Verlauf der geologischen Zeit auf unserem Planeten verstärkt die biogene Wanderung der chemischen Elemente in der Biosphäre.“

Neuere Studien stützen Wernadskijs zweites Prinzip nachdrücklich und zeigen, daß die Evolution des Lebens (soweit sie derzeit beobachtet wird) einen Zeitpfeil definiert, der sich immer in eine Richtung bewegt: hin zu einem höheren Energieverbrauch pro Art und größeren entsprechenden Auswirkungen auf die Biosphäre.32

Im größeren (kosmischen) Maßstab betrachtet, wird die Irrelevanz der physikalischen Entropie für das Verständnis der Entwicklung des Universums noch deutlicher. Nehmen wir als Beispiel die Urknalltheorie, der zufolge sich das Universum vor einigen Milliarden Jahren in einem Zustand mit der niedrigsten Entropie und der höchsten freien Energie befand und es sich seitdem (aus thermodynamischer Sicht) stetig abwärts entwickelt hat. Auch hier ist jede Zunahme des physikalischen Maßes der Entropie absolut irrelevant für die kosmologische „Unordnung“, wenn man die offensichtliche Zunahme von Ordnung und Komplexität berücksichtigt: die Entwicklung von Galaxien, Sternen, Planeten und, um unsere Sonne herum, von Leben und menschlicher Erkenntnisfähigkeit. Vielleicht hat eine Galaxie eine höhere Entropie als eine Ansammlung von kosmischem Staub oder die subatomare Suppe, die vermeintlich in den ersten Mikrosekunden nach dem Urknall existierte, aber das bedeutet keineswegs, daß sie mehr Unordnung aufweist oder in ihren Eigenschaften weniger interessant ist.

Ein Mensch, der Nahrung in körperliche Bewegung und biologische Erhaltung umwandelt, verbraucht thermodynamisch gesehen freie Energie33 und ist dennoch die Quelle kreativer Entwicklungen, mit denen die geistigen Werkzeuge und die uns zur Verfügung stehende Nutzenergie qualitativ erhöht werden: Die freie Energie des Menschen, die sich nicht an die lokal abnehmende thermodynamische freie Energie hält.

Selbst die Entropie-Interpretation der statistischen Mechanik, wonach zunehmende Entropie als Evolution hin zu Zuständen größerer Wahrscheinlichkeit, größerer Möglichkeiten gemessen wird, steht im Gegensatz zu den Veränderungen, die man im biologischen Leben und in der Menschheit beobachtet. Weit davon entfernt, sich auf Zustände größerer Wahrscheinlichkeit zuzubewegen, bewegen sich die evolutionären Veränderungen im Leben und die Veränderungen im wirtschaftlichen Leben der Menschheit auf Zustände der Nullwahrscheinlichkeit, einer vorherigen Unmöglichkeit, zu. Es entsteht eine Zukunft, die in der physischen Vergangenheit nicht hätte geschaffen werden können. Die bronzezeitliche Menschheit verfügte über eine ganze Reihe von Prozessen und Materialien, die es in der Steinzeit einfach nicht gab, ebenso wie Säugetiere über Moleküle und biologische Prozesse verfügen, die es in früheren Lebensformen wie den Reptilien nicht gab und auch nicht geben konnte, weil in früheren Lebensformen die Körpertemperatur nicht reguliert werden konnte.

Zusammenfassend läßt sich sagen, daß wir keine schlaflosen Nächte haben müssen, weil eine physikalische Größe – die Entropie – zunimmt und wir in Zukunft in einer ungeordneten Hitzesuppe zu verschwinden drohen; vielmehr sollten wir uns die tatsächliche Entwicklung des Universums und unserer Gattung im Laufe der Zeit betrachten und verstehen, daß darin gegenläufige Prozesse eine Rolle spielen. Wir müssen in unserem Verständnis des Universums die Phänomene des Lebens und der menschlichen Erkenntnisfähigkeit berücksichtigen, sonst wäre unser Wissen erschreckend unvollständig. Die zunehmende Komplexität, die zunehmende biologische Energie und die zunehmende wirtschaftliche Energie mögen lokal mit dem Zweiten Hauptsatz der Thermodynamik übereinstimmen, aber sie lassen sich keineswegs dadurch erklären. Der Zweite Hauptsatz der Thermodynamik ist nicht universell.

Gedanken über die Zeit

Das Zeitverständnis in Thermodynamik und Physik rückt die verschiedenen Arten von Zeit in Biosphäre und Noosphäre mehr in den Fokus. Um es noch einmal zu wiederholen: Die dynamischen Gesetze der Physik nach dem Ersten Hauptsatz der Thermodynamik regeln reversible Prozesse, bei denen Vorher und Nachher entgegengesetzte Zeitrichtungen sind, aber sich nicht grundsätzlich voneinander unterscheiden. Die irreversiblen Prozesse, von denen der Zweite Hauptsatz der Thermodynamik handelt, haben eine Zeitrichtung, eine grundsätzliche Unterscheidung zwischen Vorher und Nachher, basierend auf dem Konzept der physikalischen Entropie, die in Richtung des Zeitflusses zunimmt.

Es gibt drei markante Unterschiede, die sich in den Zeitabläufen lebender Prozesse und des menschlichen Denkens zeigen: Eine neue Art von Irreversibilität, ihr quantisierter Charakter und ihre Abhängigkeit vom jeweiligen Zusammenhang. Eine höhere Form der Irreversibilität zeigt sich in der Entwicklung biologischer und menschlicher „Technologien“, so daß sich Vorher und Nachher nicht durch eine skalare Größe unterscheiden, die in Richtung des Zeitflusses zunimmt, sondern durch die Tatsache, daß das Nachher nicht durch das Vorher erreicht werden kann. Das heißt, daß die Menschheit im Atomzeitalter Materiezustände schafft, die in früheren Phasen der menschlichen Entwicklung nie hätten entstehen können, weil die dafür erforderlichen Technologien nicht existierten.34 Der Zeitablauf menschlicher Entwicklung ist geprägt durch die Zunahme unseres Handlungsspielraums und nicht durch irgendein (skalares) Maß, das in jedem Kontext einen sinnvollen Wert hat.35 Die Entwicklung der Endothermie (warmblütiges Leben) war eine relativ spezifische biologische „Technologie“, die es Tieren ermöglichte, neue biologische Eigenschaften in einem bestimmten Temperaturbereich zu entwickeln und die von ihnen bewohnbaren Territorien zu erweitern. Evolutionär gesehen kommt die Endothermie nach der Exothermie.

Der Fortschritt der Evolution läßt sich quantitativ an der Zunahme bestimmter Stoffwechselprozesse im Laufe der evolutionären Entwicklung ablesen. Um nur ein Kennwert zu verwenden, betrachten wir den durchschnittlichen Energieverbrauch pro Gramm Körpermasse und Lebensdauer. Dieser Wert eignet sich besser als die Stoffwechselrate selbst, da die Stoffwechselrate mit der Körpermasse in einem Verhältnis von etwa einer Dreiviertelpotenz skaliert.36 Da eine Reihe spezifischer Zeiten (Lebensdauer, Zeit bis zur Geschlechtsreife, Herzfrequenz und Atmungsrate, zum Beispiel) etwa einer Viertelpotenz der Masse einer Spezies folgen, liefert ihr Produkt – Energie pro Masse pro Lebensdauer – einen Wert, der weitgehend charakteristisch für eine bestimmte Klasse von Tieren ist.37

Die Daten lassen eine deutliche Entwicklung im Laufe der Evolution erkennen. Aus einer Datenbank38 für Lebensdauerdaten nicht-aquatischer Wirbeltiere ergibt sich, daß Amphibien einen durchschnittlichen Energieverbrauch pro Gramm und Lebensdauer von etwa 210 kJ/g/Lebensdauer haben. Reptilien liegen mit 230 kJ/g/Lebensdauer etwas höher, während er bei Säugetieren 1.600 kJ/g/Lebensdauer und bei Vögeln 5.280 kJ/g/Lebensdauer beträgt.39 Die steigenden Werte, die für jede dieser Wirbeltierklassen in etwa charakteristisch sind, weisen auf den zunehmenden Anteil des biogenen Energieflusses im Laufe der Evolution hin.

Ein solches Maß für die Entwicklung des Lebens im Laufe der Zeit, das eine eindeutig biologische Zeit als Maßstab verwendet, ist die Art von Studie, die Wernadskij gefordert hat.40

Wernadskij hatte erkannt, daß die Biologie ein einzigartiges Licht auf das Thema Zeit werfen würde. In seinem 1938 veröffentlichten Buch „Probleme der Biogeochemie II“ schreibt Wernadskij:

„Wir erleben gegenwärtig eine äußerst wichtige Epoche in der Entwicklung der Wissenschaften. Zum ersten Mal ist die Zeit Gegenstand der Untersuchungen, etwas, was bisher stets außerhalb ihrer Sphäre lag. Dies kennzeichnet die Wissenschaft unserer Epoche und unterscheidet sie von der Wissenschaft des 19. Jahrhunderts. Es ist nun deutlich, daß die Zeit ein äußerst komplexer Ausdruck der Wirklichkeit und dieses Konzept inhaltlich äußerst reichhaltig ist.

Wenn wir von der Raumzeit sprechen, bezeichnen wir damit nur die Untrennbarkeit des einen vom anderen. Für die Wissenschaft gibt es keinen Raum ohne Energie und Materie; und in genau demselben Sinne gibt es auch keine Zeit. Die Vorstellung Minkowskis und seiner Vorläufer von der Zeit als einer vierten Dimension des Raumes ist eine mathematische Abstraktion ohne Grundlage in der wissenschaftlichen Wirklichkeit; sie ist eine Fiktion, die weder dem wirklichen Inhalt der Wissenschaft noch dem wahren wissenschaftlichen Konzept der Zeit entspricht. Natürlich kann man die Zeit in der Geometrie als Vektor darstellen. Aber eine solche Darstellung kann eben nicht alle Eigenschaften der Zeit in den Naturprozessen darstellen, welche der Naturforscher untersucht, und sie bietet im Sinne wirklichen Wissens nichts Reales. Er braucht sie nicht.

Die Wissenschaft des 20. Jahrhunderts ist nun in einer Phase, wo der Moment gekommen ist, die Zeit zu untersuchen, so wie bisher Energie und Materie untersucht werden, die den Raum erfüllen. Minkowskis Zeit, als vierte Dimension eines euklidischen Raumes betrachtet, entspricht nicht der Zeit, die wir im physikalischen Raum tatsächlich beobachten. Man sollte nicht vergessen, daß wir es bei der konkreten wissenschaftlichen Arbeit im allgemeinen nicht mit dem abstrakten absoluten Raum der Geometrie zu tun haben. Bei jedem Schritt stoßen wir auf den viel komplizierteren wirklichen Raum der Natur.“41

Menschliche Zeit

Ein ganz neues Merkmal der Zeit entsteht, wenn man den menschlichen Erkenntnisprozeß betrachtet: das Merkmal des Jetzt. Erinnern wir uns daran, daß der Erste Hauptsatz der Thermodynamik das Vorher und Nachher nur als Gegensätze unterscheidet; der Zweite Hauptsatz der Thermodynamik gibt der Zeit eine Richtung; lebende Prozesse geben der Zeit eine quantisierte Eigenschaft (wie in der zyklischen Generationszeit); und evolutionäre Veränderungen des Lebens geben der Zeit eine inkommensurable Richtung, wobei sich das Nachher vom Vorher durch Prozesse unterscheidet, die es vorher nicht geben konnte (anstatt durch die Zunahme skalarer Werte wie der Entropie). Die Bedeutungen von vorher und nachher haben sich zwar entwickelt, keine dieser Zeitarten erforderten jedoch bisher ein Jetzt.

Das Jetzt ist ein besonderer Moment, der sich vom Dann unterscheidet. In der Physik gibt es zwar ein Dann, das von anderen Danns unterschieden werden kann, aber es gibt kein Jetzt; die physikalischen Phänomene brauchen kein solches Konzept. Das Jetzt ist nicht der Moment zwischen Vorher und Nachher, sondern der Moment zwischen Vergangenheit und Zukunft. Die Gesetze der Thermodynamik unterscheiden zwischen Vorher und Nachher, aber dieses Vorher und Nachher kann vor oder nach einem bestimmten Moment, einem beliebigen Dann liegen. Vorher und Nachher sind nicht dasselbe wie Vergangenheit und Zukunft. Was bedeutet „genau jetzt“ physikalisch? Was unterscheidet das Jetzt grundlegend von dem, was vor einer Stunde war?

Darüber hinaus ist mit Einsteins Relativitätstheorie, d. h. dem Verschwinden der Gleichzeitigkeit, das Konzept einer universellen Zeit, der Möglichkeit eines gemeinsamen Zeitmoments für verschiedene Beobachter, verschwunden. Entsinnen wir uns, daß für einen Beobachter zwei Ereignisse aufeinander zu folgen scheinen, während für einen anderen Beobachter beide Ereignisse gleichzeitig zu sein scheinen.42 Somit kann es keinen einzelnen Moment in der Zeit, keine universelle Gleichzeitigkeit geben. Es gibt kein universelles „Jetzt“. Wie aber kann das Jetzt eine Bedeutung haben?

Was für Phänomene sind für die Existenz eines „Jetzt“ erforderlich?

Es liegt in der Natur des freien Willens, daß der Mensch ein Jetzt kennt; es ist die Zeit der Entscheidung. Die Möglichkeit, willentlich nichtlineare Veränderungen herbeizuführen, wie sie bei Lebewesen nur im Laufe der Evolution zu beobachten sind, ist dem menschlichen Individuum in jedem Augenblick gegeben: die Möglichkeit, in jedem Jetzt Entscheidungen zu treffen, die nicht vorherbestimmt sind und die als kreative Entscheidungen die Zukunft grundlegend von der Vergangenheit unterscheiden, indem sie den möglichen Handlungsbereich des Menschen dramatisch verändern. Dieses Jetzt der Entdeckung, diese Momente schöpferischer Einsicht sind der Grund dafür, daß die menschliche Ökonomie ein besonderes Merkmal hat, das es in anderen Lebensformen nicht gibt.

Der Lauf der Menschheit „tendiert“ nicht unaufhaltsam in irgendeine Richtung; er ist eine Reihe von Jetzt, von ständigen Entscheidungsmöglichkeiten. Wenn die menschliche Zeit genutzt wird, um eine grundlegende Entdeckung zu machen, wird die ureigenste Substanz des Universums für den menschlichen Geist sichtbar: die Substanz inkommensurabler Entwicklung selbst.

Was sind „universelle“ Prinzipien?

Wenn es mit Gefahren verbunden ist, Prinzipien über den Bereich ihrer Entdeckung hinaus zu erweitern, können dann jemals wirklich universelle Prinzipien erkannt werden? Hören wir diese Warnung von Wernadskij:

„In einem Fall begründete der junge französische Ingenieur Sadi Carnot im Jahr 1824 die Thermodynamik. Das Carnotsche Prinzip definiert den unidirektionalen Verlauf eines Prozesses in der Zeit. Dreißig Jahre später übertrug Rudolph Julius Clausius, damals Professor in Zürich, mit dem Prinzip der Entropie diesen unidirektionalen Prozeß (der in der Raumzeit geometrisch durch einen polaren Zeitvektor ausgedrückt wird) auf die gesamte Realität, indem er das ,Ende der Welt‘ definierte. In dieser Form war dies die Extrapolation eines logischen Gedankens, aber kein Phänomen der Realität.“43

Wenn es universelle „Phänomene der Wirklichkeit“ gibt, wie lassen sie sich auffinden? Auf welcher Grundlage könnte man potentiell gültige Einsichten in universelle Prinzipien gewinnen, wenn Extrapolationen wissenschaftlicher Prinzipien nicht verläßlich sind? Was kann man über das Universum aussagen, wenn unser Wissen immer unvollständig ist?

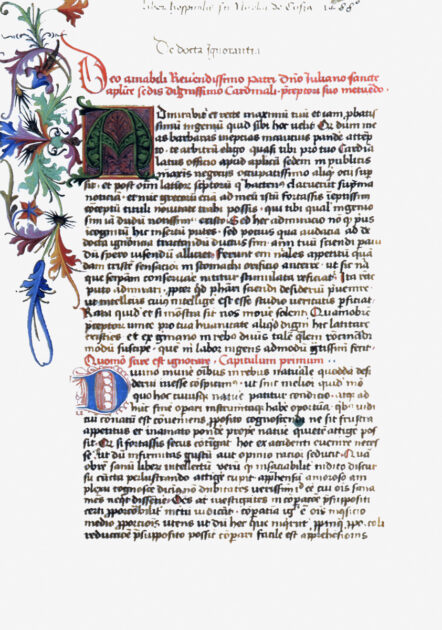

Nikolaus von Kues geht in seinem Werk De docta ignorantia (Über die belehrte Unwissenheit) – das Johannes Kepler inspirierte und die moderne Wissenschaft begründete – von der Betrachtung dessen aus, was er als das Universellste des Universellen ansah, nämlich Gott, um sich dann im Zusammenhang mit seiner Gotteserkenntnis über das Universum Gedanken zu machen. Cusas zentrales Wissenskonzept, die belehrte Unwissenheit und die coincidentia oppositorum (der Zusammenfall der Gegensätze), beruht nicht auf kleinen Teilen oder kleinen Ideen, um zu großen aufzusteigen, sondern beschreibt einen spezifischen Weg, wie ein Mangel an Wissen selbst ein geeignetes Mittel ist, um neue Konzepte auszudrücken. So schreibt Cusa, daß Gott das uneingeschränkt Größte ist, und „weil sich ihm nichts gegenüberstellen läßt, so fällt mit ihm zugleich auch das Kleinste zusammen“, und Gott ist das Licht, „das die Finsternis des Nichts erleuchtet“.44 Dies sind Gegensätzlichkeiten, spezifische Unaussprechlichkeiten, um den Leser zu einem unbegreifbaren Begriff zu führen, indem die Unbegreifbarkeit konkreter gemacht wird.

Cusa spricht dann über das Universum, wobei er seine Gedanken erneut in Unaussprechlichkeiten kleidet, die sich aus dem Versuch eines Verständnisses ergeben, das unter dem für die Erkenntnis erforderlichen Niveau liegt. Er sagt, daß das, was weniger als die Wahrheit ist, die Wahrheit nicht genau messen kann, und wendet diese Erkenntnis auf die Astronomie an. Cusa behauptet, kein Planet könne sich auf einem Kreis bewegen, da es in der erschaffenen Welt einen vollkommenen Kreis, der absolute Vollkommenheit verkörpert, nicht geben und deshalb nicht die Ursache für Bewegung sein kann.45 Ebenso sei eine vollkommen gleichförmige (kreisförmige) Bewegung unmöglich: Wie könnten zwei Bewegungen so gleich sein, daß sie nicht zu einer noch größeren Gleichheit fähig wären? Somit scheiden sowohl der Kreis als auch die gleichförmige Bewegung als wahres Mittel zum Verständnis der Planeten aus. Was bleibt dann? Nichts, in der Sprache, die Cusa zu überwinden suchte. Sein Anhänger Johannes Kepler wandte die Physik auf die Astronomie an und schuf damit eine höhere Ebene des Denkens, mit der er die Unmöglichkeit des von Cusa entwickelten geometrischen Verständnisses der Astronomie auflöste. Keplers Verwendung eines physikalischen Prinzips, dessen Nutzung sich in jedem Augenblick veränderte, war für seine Zeitgenossen unbegreiflich, schuf aber eine völlig neue Grundlage für die Astronomie und eröffnete den Weg zur modernen Wissenschaft.

Aus diesem astronomischen Beispiel läßt sich eine allgemeine Schlußfolgerung ziehen. Im Gegensatz zu der aristotelischen Ansicht, daß Gegensätze nicht nebeneinander bestehen können, oder der Ansicht der Logiker, daß alle ableitbaren Schlüsse in den ursprünglichen Prämissen enthalten sind, vertrat Cusa die Auffassung, daß der Prozeß der Entdeckung selbst primär ist, wobei Widersprüche den Verstand dazu bringen, ein neues Konzept zu entwickeln, das sich nicht aus der Vergangenheit ableiten läßt – eine Schlußfolgerung, die den Prämissen widerspricht und nicht aus ihnen folgt. Cusa war der Überzeugung, daß man durch diesen Prozeß, der Erkenntnis durch die belehrte Unwissenheit, dem Sehen Gottes am nächsten kommen kann. Paradoxe durch die Entwicklung neuer Metaphern aufzulösen, ist mehr als eine Technik, um zu physikalischen Wahrheiten zu gelangen: Dieser Prozeß ist die wahrste Substanz der Natur.46

Jeder Mensch wird mit dem Potential geboren, diesen Entdeckungsprozeß anzuwenden: in der Vorstellung von Unsterblichkeit zu leben, Prinzipien zu entdecken und zur Verbesserung der Gesellschaft anzuwenden, wobei Verbesserung darin besteht, die Fähigkeit der Mitmenschen zu erhöhen, an diesem speziell menschlichen Verhalten teilzuhaben.

Die Schaffung einer solchen Gesellschaft, frei vom Oligarchismus, der gegenwärtig einen globalen thermonuklearen Krieg heraufzubeschwören droht, ist die schönste, menschlichste und vordringlichste Aufgabe, die sich der Menschheit heute stellt.

Zuschriften an den Autor unter jasonaross@gmail.com

Fußnote(n)

- Entropie, ein meßbares physikalisches Konzept, das entwickelt wurde, um die Menge an Energie zu erklären, die zur Verrichtung nützlicher Arbeit zur Verfügung steht, hat die Eigenschaft, bei allen Prozessen in geschlossenen Systemen zuzunehmen (oder konstant zu bleiben). Diese zunehmende Entropie, die physikalischen Prozessen eine zeitliche Richtung gibt, wurde häufig ungenau als Zunahme der „Unordnung“ eines Systems beschrieben. Dieses Konzept der Unordnung wurde dann auf Bereiche angewandt, die weit über die Physik und die physikalische Chemie hinausgehen. Vielen Schülerinnen und Schülern wird Entropie durch die Analogie der zunehmenden Unordnung auf einem Schreibtisch oder in einem Zimmer beigebracht, wenn man zu faul zum Aufräumen ist. Aber die Gegenstände auf einem Schreibtisch bewegen sich nicht von selbst oder „tendieren“ von selbst zu einer neuen Anordnung; sie werden von Menschen bewegt.[↩]

- Wladimir I. Wernadskij, „Die Erforschung des Lebens und die Neue Physik“, in FUSION, Jg. 36, Heft 1, 2015.[↩]

- Weitere Informationen über den „flachen“ und „gekrümmten“ Raum siehe Bernhard Riemanns Habilitationsschrift „Ueber die Hypothesen, welche der Geometrie zu Grunde liegen“.[↩]

- Die Wellentheorie des Lichts warf eine neue Frage auf: Was ist das Medium, das sich wellenförmig bewegt? Eine Meereswelle basiert auf Wasser. Schallwellen beruhen auf der Kompression von Luft. Was ist mit Licht?[↩]

- Dadurch war das Wellenverständnis des Lichts nicht aus der Welt: Während einige Experimente die Teilchennatur des Lichts zu bedingen schienen, verlangten andere (in der Tat die meisten), daß das Licht als Welle auftrete. Weitere Informationen über die Entstehung des Quantensystems und die Fehler der Kopenhagener Interpretation der Quantenmechanik finden Sie in dem Video des Autors A New Quantum Physics: Rejecting Zeus.[↩]

- Im Jahr 1905 entdeckte Einstein, daß es in der Wirklichkeit eine Verbindung zwischen Energie und Materie gibt. Weitere Entdeckungen, die in den folgenden zwei Jahrzehnten gemacht wurden, verlangten ein neues Konzept, um die Trennung zwischen der Diskretheit von Materie und der Kontinuität von (Licht-)Energie zu überwinden.[↩]

- Siehe Anmerkung 2.[↩]

- Lavoisier entwickelte auch ein eindrucksvolles Erhaltungsprinzip: Bei allen chemischen und mechanischen Veränderungen bliebe die Gesamtstoffmenge unverändert, und die Gesamtmasse jedes einzelnen Elements würde sich ebenfalls nicht ändern.[↩]

- Vor Ableitung des mechanischen Wärmeäquivalents wurde die Kalorie – ein Maß für die Wärme, die zur Änderung der Temperatur eines Körpers erforderlich ist – als einem anderen Bereich der Natur zugehörig angesehen als das Joule, mit dem mechanische Arbeit gemessen wurde. Joule stellte fest, daß es eine direkt meßbare Äquivalenz zwischen der Menge an Wärmeenergie und mechanischer Energie gibt: eine Kalorie entspricht etwa 4 Joule. Die Kalorien in Lebensmitteln sind eigentlich Kilokalorien und entsprechen jeweils etwa 4 Kilojoule.[↩]

- Dieses Konzept geht auf Leibniz zurück, der in seinem Specimen Dynamicum von 1695 über den Zusammenhang zwischen vis viva (lebendige Kraft – heutige kinetische Energie) und vis mortua (tote Kraft – heutige potentielle Energie) schrieb.[↩]

- Ein Verbrennungsmotor, der bei einer Temperatur von 1000 K (730 °C oder 1340 °F) als Th arbeitet, hätte in einer Umgebung mit einer Temperatur von 300 K (30 °C oder 80 °F) als Tk einen maximalen Wirkungsgrad von (Th – Tk)/Th oder (1000 K – 300 K)/1000 K = 700/1000 = 70 %. Somit könnten höchstens 70 % der im Motor erzeugten Wärme in mechanische Arbeit umgewandelt werden, während 30 % lediglich die kältere Umgebung erwärmen würden. Dies ist der maximale theoretische Wirkungsgrad eines Motors, der bei diesen Temperaturen arbeitet.[↩]

- Man beachte, daß dabei weder Entropie noch der Zweite Hauptsatz der Thermodynamik erforderlich sind, auf die weiter unten eingegangen wird.[↩]

- Wenn man zum Beispiel die Position und die Geschwindigkeit eines schwingenden Pendels zu einem bestimmten Zeitpunkt kennt, kann man seine spätere Bewegung vorhersagen und auch seine vorherige Bewegung rekonstruieren.[↩]

- Eine ideale Wärmekraftmaschine ist im Umkehrschluß ein idealer Kühlschrank. Die Umwandlung von Wärme in Arbeit, bei der ein gewisser Wärmefluß in einen kalten Behälter stattfindet, kann durch die Anwendung von Arbeit umgekehrt werden, um die Wärme wieder dem warmen Behälter zuzuführen, wodurch ein Wärmefluß aus dem kalten Behälter entsteht. Ideale Wärmekraftmaschinen und ideale Kühlschränke sind ein und derselbe Prozeß, nur in entgegengesetzter Zeitrichtung betrachtet.[↩]

- Damit lassen sich vielleicht die Schwierigkeiten erklären, die Kinder haben, ein Gefühl für links und rechts zu entwickeln.[↩]

- In Max Plancks Vorlesungen über Thermodynamik (Verlag von Veit & Comp., Leipzig, 1897, S. 72) heißt es: „Vom Standpunkt des ersten Hauptsatzes aus betrachtet erscheinen also Anfangszustand und Endzustand eines jeden Prozesses als vollkommen gleichwerthig.“[↩]

- Für Leser, die eine genauere Erläuterung wünschen, läßt sich die Entropieänderung kurz als

ΔS = ∫d Q/T

angeben, wobei die Entropieänderung S das Integral der absorbierten Wärme Q geteilt durch die Temperatur ϑ ist. In seinen Vorlesungen über Thermodynamik leitet Planck eine allgemeine Funktion für die Entropie eines Gases ab:

S = M (cv log ϑ + R/m log υ + const.) ,

wobei S die Entropie, M die Masse des Gases, cv die spezifische Wärme des Gases bei konstantem Volumen (die Wärmemenge, die zugeführt wird, um seine Temperatur zu ändern), ϑ die Temperatur, R die ideale Gaskonstante, m das Molekulargewicht und υ das Volumen pro Masse des Gases ist, woraus er zeigt, daß die Änderung der Entropie unter bestimmten Bedingungen ΔS = ∫d Q/T ist. Die Entropie war ein neues physikalisches Konzept, das sich nicht aus früheren Theorien ableiten ließ und dessen Zunahme mit dem Vorwärtsfließen der Zeit übereinstimmte.

Die Entropie ändert sich nicht, wenn ein Gas durch äußere Arbeit komprimiert oder expandiert wird, ohne daß dabei Wärme fließt, wie in einem idealen Gasdruckstoßdämpfer, so daß ein solcher Prozeß reversibel ist.[↩]

- Die Zunahme der Entropie gibt nun die Richtung der Zeit an. Die dynamischen Gesetze der normalen Physik geben eine Zeitrate an, ohne ihre Richtung zu definieren.[↩]

- Ideal in dem Sinne, daß Kompression und Expansion sehr langsam ablaufen und der Zylinder so gut isoliert ist, daß keine Wärme an die Umgebung abgegeben oder von ihr abgegeben wurde.[↩]

-

Zwei kurze Beispiele mögen hilfreich sein. Betrachten wir zunächst zwei Körper mit unterschiedlichen Temperaturen, Th (heißer) und Tk (kälter), und lassen wir Wärme von dem heißen Körper zu dem kälteren fließen. Mit ΔS = ∫d Q/T können wir sagen, daß die Entropieänderung des heißen Körpers, der Wärme verliert, –Q/Th ist, während die Änderung für den kälteren Körper, der Wärme gewinnt, Q/Tk ist. Die Menge Q (Wärmefluß) ist für beide Körper gleich, da wir davon ausgehen, daß die gesamte Wärme, die von dem heißen Körper fließt, in den kalten Körper gelangt. Die gesamte Entropieänderung ist also

ΔS = –Q/Th + Q/Tk .

Da Th größer ist als Tk, ist der negative Term –Q/Th kleiner als der positive Term Q/Tk, und die Entropie hat zugenommen.

Ein zweites Beispiel ist die Ausdehnung von Gas, ohne daß Arbeit verrichtet wird und ohne äußeren Wärmefluß. Nehmen wir zwei durch ein Ventil verbundene Gasbehälter, von denen einer voll und der andere völlig leer ist. Wird das Ventil nur ein wenig geöffnet, strömt das Gas in den leeren Tank, bis beide den gleichen Druck haben. In Experimenten wurde festgestellt, daß sich die Temperatur des Gases insgesamt nicht ändert, und es wurde gezeigt, daß die Energie eines Gases nur von seiner Temperatur, nicht aber von seinem Druck oder Volumen abhängt. Daher ergibt dieses Experiment keine Änderung der inneren Energie des Gases. Wenn wir jedoch die Plancksche Entropie,

S = M (cv log ϑ + R/m log υ + const.) ,

vor und nach der Bewegung des Gases verwenden, sehen wir, daß der einzige Term, der sich geändert hat, υ ist, das Volumen pro Masse des Gases, das sich auf 2 υ verdoppelt hat. Daher ist die Entropieänderung, ohne Berücksichtigung der unveränderten Größen,

ΔS = M (R/m log 2 υ) – M (R/m log υ) .

Dies vereinfacht sich zu

ΔS = M R/m (log 2 υ – log υ) = M R/m log 2 ,

was einen positiven Wert hat. Die Entropie des Gases hat mit dieser Ausdehnung zugenommen, und dies ist in der Tat die Richtung, in der der Prozeß immer zu beobachten ist. Gase dehnen sich aus, um verfügbare Volumen zu füllen, anstatt sich spontan zu konzentrieren und ein Vakuum zu hinterlassen.[↩]

- Betrachten wir noch einmal das Beispiel aus der vorangegangenen Fußnote, bei dem das in einem Tank konzentrierte Gas in der Lage war, beide Tanks zu füllen. Wenn dieser gesamte Prozeß aufgezeichnet und rückwärts abgespielt würde und wir ihn mit einem imaginären Molekularmikroskop beobachteten, würde die Bewegung der Gasteilchen in umgekehrter Richtung (Konzentration in einem Tank und Entleerung des anderen) nicht gegen die Gesetze der Physik verstoßen. An der Dynamik des Rückwärtsvideos wäre nichts auszusetzen. Dennoch wird dies bei Gasen nie beobachtet. Wie kann die Bewegungsrichtung des Gases durch die Entropie im Großen erklärt werden, während die Untersuchung seiner Teilchen einen Prozeß offenbart, der in die andere Richtung gehen könnte? Mit dieser Art von Problem beschäftigte sich Boltzmann bei seiner Behandlung der Entropie.[↩]

- Zwar wird der Zweite Hauptsatz häufig als Zunahme der „Unordnung“ ausgedrückt, wobei auf Beispiele für die Unordnung von Objekten im Makrobereich verwiesen wird, die sich nicht von selbst verändern (wie unordentliche Zimmer und unaufgeräumte Schreibtische), doch handelt es sich dabei um eine ganz unzulässige Anwendung des alltäglichen Wortes „Unordnung“. Es wird aus seinem sinnvollen Kontext in Mikrozuständen (wo es immer noch ein bedauerliches Wort ist) auf den völlig anderen Kontext in Makrozuständen übertragen. Wie Professor Frank Lambert humorvoll feststellte, bewegen sich die Objekte in einem Raum nicht von Natur aus oder geraten selbsttätig in Zustände der Unordnung. Sie sind kein geschlossenes System, da die Ursache für ihre Bewegung die Menschen sind, die sie bewegen, und nicht die Objekte selbst. Weitere Informationen über die pädagogische Katastrophe der Verwendung von „Unordnung“ zur Erklärung der Entropie finden Sie auf seinen lesenswerten Internetseiten unter secondlaw.oxy.edu.[↩]

- Kehren wir zu dem Beispiel in den Fußnoten 16 und 17 zurück. Wenn sich die Bewegung aller Gasteilchen sofort umkehren würde, sobald sie den zweiten Tank gefüllt haben, würden sie sich tatsächlich alle in den ersten Tank zurückbewegen. Aber wie viele der möglichen Konfigurationen von Teilchenpositionen und -impulsen in den beiden Tanks würden dazu führen, daß sich alle Teilchen in einen Tank bewegen, wenn man von dem allgemeinen Zustand zweier Tanks voller Gas ausgeht? Nur eine sehr, sehr kleine Zahl unter der unvorstellbar großen Zahl möglicher Konfigurationen. Aus diesem Grund, so würden die statistischen Mechaniker sagen, ist nicht zu beobachten, daß sich Gase spontan in kleineren Volumina konzentrieren. Obwohl dies vom molekularen Standpunkt aus nicht völlig unmöglich ist, ist es unglaublich unwahrscheinlich.[↩]

- Vor der Metallurgie diente Malachit als Kosmetikum, wurde aber zum Haupterz für die Kupferproduktion, als es als Ressource in die Metallurgie eingeführt wurde. Erdöl war vor dem Chemie-Zeitalter keine Ressource – es war ein schmieriger Schlamassel.[↩]

- Außer in sehr kalten Gebieten, wo der Wirkungsgrad von Wärmepumpen zu gering ist, um sinnvoll zu sein.[↩]

- Lyndon LaRouche, „Was Sie schon immer über Wirtschaft wissen wollten“, Böttiger-Verlag, Wiesbaden, 1985, S. 29.[↩]

- Die Energie nuklearer Umwandlungen ist fünf bis sechs Größenordnungen dichter (100.000 bis 1.000.000 Mal größer) als die von chemischem Brennstoff. Siehe das Video von Jason Ross, Forging Fusion.[↩]

- Wie zum Beispiel der Einsatz von fusionsgetriebenen Raumschiffen, die jeden Teil des inneren Sonnensystems innerhalb von Wochen statt Jahren erreichen können. Dies wäre auch für die Verteidigung der Erde gegen Asteroiden und Kometen unerläßlich.[↩]

- Was zu Thompsons ungenauer Schätzung des Alters der Sonne führte.[↩]

- Siehe das 2. Kapitel in Lyndon LaRouche, a. a. O.[↩]

- Diese Rede, die später als Anhang in die französische Ausgabe von Wernadskijs Buch Die Biosphäre aufgenommen wurde, ist auf deutsch erschienen unter dem Titel „Über die Evolution der Arten und die lebende Materie“, Übersetzung einer Rede Wernadskijs vor der Gesellschaft der Naturforscher in Leningrad am 5. Februar 1928, in FUSION 02/2013.[↩]

- Siehe Benjamin Deniston, “Biospheric Energy-Flux Density,” 21st Century Science & Technology, Spring 2013.[↩]

- In diesem Bericht verwenden wir den Begriff „freie Energie“ im Sinne der Thermodynamik, wie sie von Gibbs entwickelt wurde. Sie hat nichts mit „Nullpunktenergie“, „Vakuumenergie“ oder irgendeiner anderen Form von angeblicher Energie zu tun, die „frei“ im Sinne von kostenlos ist.[↩]

- Die Zeit allein hat den zukünftigen Zustand nicht bewirkt.[↩]

- Lyndon LaRouche hat auf die Arbeit von Bernhard Riemann über Abelsche Funktionen verwiesen, um steigende Komplexitätsgrade direkter auszudrücken, die mit der vorherigen Ebene inkommensurabel sind. Zu diesem Thema siehe auch zwei Videovorträge von Jason Ross, Bernhard Riemann: Potential und Abelsche Funktionen, Teil 1 und Teil 2 (auf Englisch).[↩]

- Ein Kamel (434 kg), das 150mal so viel wiegt wie ein Opossum (3 kg), verbraucht zum Beispiel nur 42mal so viel Energie (225 W) wie das Opossum (5,3 W). Unter Verwendung der Dreiviertel-Beziehung ergibt 1503/4 ≈ 42. Diese Dreiviertel-Leistungsbeziehung wurde von Max Kleiber in den 1930er Jahren entdeckt. Sein empirisches Ergebnis wurde durch neuere Daten weitgehend bestätigt, findet aber keine befriedigende Erklärung aus allgemeineren Prinzipien.[↩]

- Diese Kombination aus Stoffwechselrate (Masse0,75) mal Lebensdauer (Masse0,25) ergibt einen Wert, der proportional zur Masse selbst ist. Teilt man ihn durch die Masse, erhält man eine Zahl, die eine Tierklasse charakterisiert. Die Beziehung ist zwar nicht exakt (Regressionslinien ergeben Potenzen von 0,88 bis 1,14 der genannten Klassen), aber sie deutet zumindest auf die Möglichkeit einer Quantisierung der biologischen Zeit hin.[↩]

- Die AnAge-Datenbank. Verweis: R. Tacutu, T. Craig, A. Budovsky, D. Wuttke, G. Lehmann, , D. Taranukha, J. Costa, V. E. Fraifeld, J. P. de Magalhaes, (2013) „Human Ageing Genomic Resources: Integrierte Datenbanken und Werkzeuge für die Biologie und Genetik des Alterns“. Nucleic Acids Research 41(D1):D1027-D1033.[↩]

- Das Leben der Vögel hat sich mehr als 100 Millionen Jahre später entwickelt als das der Säugetiere. Das Fliegen selbst spielt bei dem hohen Energieverbrauch der Vögel die wichtigste Rolle. Unter den Säugetieren ist der Energieverbrauch pro Masse und Lebensdauer bei Fledermäusen doppelt so hoch wie bei landlebenden Säugetieren. Und bei den Vögeln ist der lebenslange Energieverbrauch pro Gramm Körpergewicht bei flugunfähigen Vögeln viel geringer – etwa halb so hoch.[↩]

- In Lebensprozessen unterschied Wernadskij zwischen Stoffwechselzeit, Generationszeit und Evolutionszeit und berücksichtigte die spezifischen Merkmale der jeweiligen Zeit, „The Problem of Time in Contemporary Science“, unveröffentlichte englische Übersetzung.[↩]

- Wladimir Wernadskij, „Probleme der Biogeochemie II: Über die Unterschiede zwischen lebenden und nichtlebenden Naturkörpern in der Biosphäre“, FUSION, 21. Jg., Nr. 3, 2000, S. 24. Hervorhebung im Original.[↩]

- Um dieses Thema geht es in dem Video The Extraordinary Genius of Albert Einstein ab 1:04:30.[↩]

- Wernadskij, a. a. O., „The Problem of Time in Contemporary Science“.[↩]

- Nikolaus von Kues, De docta ignorantia, Buch 1, Felix Meiner Verlag, Hamburg, 1994.[↩]

- Ebenda, Buch 2.[↩]

- Jason Ross, On Metaphor: an Intermezzo.[↩]